-

Innlegg

26 089 -

Ble med

-

Besøkte siden sist

-

Dager vunnet

3

Innholdstype

Profiler

Forum

Hendelser

Blogger

Om forumet

Alt skrevet av N o r e n g

-

RTX 5090 - 8900 XTX (9070 XT) Utgivelse dato - Rytker?

N o r e n g svarte på simalarion sitt emne i Skjermkort

Med tanke på at dette var en AMD-lansering med færre interesserte i utgangspunktet tviler jeg sterkt på at det var sendt ut flere Radeon-kort enn f. eks. 5070 Ti -

RTX 5090 - 8900 XTX (9070 XT) Utgivelse dato - Rytker?

N o r e n g svarte på simalarion sitt emne i Skjermkort

Vitsen er å redusere produksjonskostnadene. Navi 31 og 32 er dyre å lage fordi MCD-ene som kobles mot GCD-en krever en "brikke" for å kommunisere på høye nok frekvenser. -

RTX 5090 - 8900 XTX (9070 XT) Utgivelse dato - Rytker?

N o r e n g svarte på simalarion sitt emne i Skjermkort

Komplett gikk faktisk ned en kort periode denne gangen også, men var bare 5 minutter eller noe -

RTX 5090 - 8900 XTX (9070 XT) Utgivelse dato - Rytker?

N o r e n g svarte på simalarion sitt emne i Skjermkort

Crysis 2 fikk en DX11-oppdatering etter lansering som kjørte grafikken til himmels og ytelsen i dass for datidens PCer. Crysis 3 var også rimelig hard kost for PCer ved lansering. På den tida var gaming-skjermkort en av TSMCs største kunder på nye prosesser, i dag er det datasenter og mobiltelefoner som er på de siste og dyreste nodene. Indiana Jones and the Great Circle kjører forøvrig særdeles bra om man ikke har på Full RT. -

RTX 5090 - 8900 XTX (9070 XT) Utgivelse dato - Rytker?

N o r e n g svarte på simalarion sitt emne i Skjermkort

Både 4070 Ti og 3080 Ti har vært slik at nesten alle spill kunne kjøres på maksimale innstillinger i 4K, med et par unntak designet for 4090. Ut fra den minimale progresjonen Nvidia leverer med Blackwell er det liten grunn til å tro at dette vil endre seg drastisk. Selv i dag er det jo nærmest ingen spill som kjører uakseptabelt på en komboen 9900K og 2080 Ti, dette er da toppkomponenter fra 2018. Årsaken er at de er kraftigere enn en PS5, og de fleste spill designes for å la seg kjøre i 60 fps på PS5 i disse dager. Skjermkort varer mye lengre enn for 10 år siden, og pris/ytelse endres ikke drastisk i løpet av et par år lengre. 40-serien kom ut med praktisk talt samme pris/ytelse som den utgående 30-serien, og den eneste forbedringen i pris/ytelse i løpet av de to årene 40-serien varte var lanseringen av SUPER-kortene (som forbedret pris/ytelse med ca 20%). Sist gang vi hadde en stor forbedring på pris/ytelse-fronten var med lanseringen av 30-serien, før kryptomining og COVID viste Nvidia at folk var villige til å betale langt mer enn tidligere antatt. AMD er heller ikke et godt alternativ. De priser ikke kortene lavt nok i forhold til manglene; RDNA3 og 2 vil ikke få FSR4, ytelsen i RT er begredelig, og om 18-24 måneder kommer UDNA-kortene som vil sette spikeren i kista på RDNA-utvikling (på samme måte som at RDNA satte spikeren i kista på Vega-utvikling). Når DLSS4 Performance gir bedre bildekvalitet enn FSR3.1 Quality sier det seg selv at det ikke lenger er gyldig å sammenligne ytelsen direkte. -

RTX 5090 - 8900 XTX (9070 XT) Utgivelse dato - Rytker?

N o r e n g svarte på simalarion sitt emne i Skjermkort

Det eneste Nvidia har bommet på i denne omgangen var å kutte produksjonen av 40-serien for tidlig. Hvis Proshop selger et 5090 for 33 000 kr, og folk er villige til å betale 45 000 kr på finn er det jo åpenbart tapt profitt for Proshop. Det blir nærmere 6 000 000 kr ekstra inntjening bare på de 600 kortene som gikk i går. -

RTX 5090 - 8900 XTX (9070 XT) Utgivelse dato - Rytker?

N o r e n g svarte på simalarion sitt emne i Skjermkort

Jeg er ærlig talt sjokkert over at butikkene ikke kjører auksjon. -

RTX 5090 - 8900 XTX (9070 XT) Utgivelse dato - Rytker?

N o r e n g svarte på simalarion sitt emne i Skjermkort

Jeg er ikke så sikker, når AI-boblen imploderer tror jeg TSMC vil få mye "fritid", som vil føre til at nye prosessnoder vil bli lavere priset. Deepseek kom ikke som noen stor overraskelse, det er begrenset hvor bra AI kan bli. Dessuten virker det som "alles" løsning på å lage bedre maskinlæringsmaskiner raskere er å lage stadig større og mer innfløkte datamaskiner i håp om å trene stadig større og mer innfløkte modeller. De nye Blackwell-datasentrene fra Nvidia er mer effektive enn Hopper var, men veldig mye av forbedringene skyldes stadig høyere strømforbruk og større brikker. -

RTX 5090 - 8900 XTX (9070 XT) Utgivelse dato - Rytker?

N o r e n g svarte på simalarion sitt emne i Skjermkort

Hvis Nvidia hadde laget Blackwell på TSMC 3nm kan du banne på at 5090 hadde kostet 50000 kr, og 5080 25000 kr -

RTX 5090 - 8900 XTX (9070 XT) Utgivelse dato - Rytker?

N o r e n g svarte på simalarion sitt emne i Skjermkort

Ja, da kjøpte du jo 6950XT for lanserings prisen på 12000 kr eller hva det var 🤣 -

RTX 5090 - 8900 XTX (9070 XT) Utgivelse dato - Rytker?

N o r e n g svarte på simalarion sitt emne i Skjermkort

Nå ja, det er et par ting å tenke på med 9070: Dette blir siste generasjon med RDNA, etter 9070 går AMD tilbake til samme arkitektur for datasenter og forbruker. Det vil si at alle forbedringer som kommer til fremtidige arkitekturer vil mest sannsynlig ikke komme til RDNA4 (på samme måte som at RDNA3 mest sannsynlig ikke får FSR4). FSR4 skal være en betydelig forbedring fra FSR3, men nå har Nvidia kommet med en kraftig forbedring av DLSS. Hvis de er like gode (jeg tviler) er det heller ikke like bakoverkompatibelt som DLSS. Bruktverdien på Radeon-kort er også relativt dårligere enn Nvidia-kort. -

RTX 5090 - 8900 XTX (9070 XT) Utgivelse dato - Rytker?

N o r e n g svarte på simalarion sitt emne i Skjermkort

At L2 og minnet har høyere latency er ikke noen stor overraskelse. Det er et større areal å søke gjennom L2 på nå. Minnet er også spredd ut over et større areal, og command/address-bussen er sannsynligvis halvert i frekvens sammenlignet med GDDR6 for å skalere mot høyere frekvenser. At L1-båndbredde har gått ned er imidlertid merkelig. -

RTX 5090 - 8900 XTX (9070 XT) Utgivelse dato - Rytker?

N o r e n g svarte på simalarion sitt emne i Skjermkort

Typisk er forskjellen på slike kort minimal. TDP-en på 360W er et "worst-case" tilfelle, i praksis vil nok forbruket ligge under 300W i likhet med 4080 Super. Den grunnleggende PCB-en har også mer enn nok strømforsyning, Nvidia har hatt mer enn nok strømforsyning på kortet siden 20-serien også. -

RTX 5090 - 8900 XTX (9070 XT) Utgivelse dato - Rytker?

N o r e n g svarte på simalarion sitt emne i Skjermkort

En SM er det nærmeste du kommer en prosessorkjerne i en Nvidia-GPU. 4090 har 128 SM-er, 4080 Super har 82. Hver SM kan utføre et gitt antall FP32-operasjoner per sekund (derfor måles GPU-er ofte i antall FLOPS). I tidligere generasjoner (20-serien og bakover) var det slik at antall SM-er ganget med klokkefrekvens var en veldig god ytelsesindikator per generasjon. Hvis antallet SM-er doblet seg, pleide også ytelsen å doble seg. Det stemmer også relativt greit med 30-serien. Man skulle tro at 4090 var 128/82 = 1.6 ganger ytelsen til et 4080 Super, det er ikke i nærheten av å være sant. Hver gang spillet skal tegne en 3D-modell, "male" teksturer, og beregne lys, må en SM gjøre dette. Det aller meste kan utføres parallelt, og av flere SM-er hvis det er nok piksler å regne ut. Problemet oppstår hvis det ikke er nok oppgaver for hver SM å holde på med samtidig, da vil noen av SM-ene stå i ro og gjøre ingenting. Grunnen til at 4090 ikke er spesielt mye bedre enn 4080 Super på "lave" oppløsninger er fordi mange av oppgavene ikke lar seg fordele ut over flere SM-er. Store deler av GPU-en blir dermed stående og tvinne tommeltotter i vent på å få gjøre noe. På høyere oppløsning blir det flere piksler å regne på, som lar større andel av GPU-en jobbe samtidig. -

RTX 5090 - 8900 XTX (9070 XT) Utgivelse dato - Rytker?

N o r e n g svarte på simalarion sitt emne i Skjermkort

AMD har jo ikke hatt en eneste god lansering av skjermkort de siste 15 årene, det er alltid noe som er eller går galt 🤣 Gjennomsnittlig er forbruket langt lavere. Igor's Lab viser at de fleste spill legger seg komfortabelt under 500W, og ofte 400W. Det er i svært korte perioder oppe i 800W. Der8auer gjorde lignende observasjoner. Når alle SM-ene er i bruk kan GB202 komme opp i 800W (jeg tipper 1500W er nærmere sannheten fra tidligere erfaring), men mange spill er rett og slett ikke parallelle nok. Dette var et "problem" med 4090 også, men har blitt enda mer tydelig med 5090. Disse svingningene i strømforbruk fører til at det blir ekstremt vanskelig å forhindre spolene fra å hvine. ROG er kort for Republic Of Gamers Rogue er en slyngel eller tyv. Rouge er en farge: https://palettemaker.com/colors/rouge -

RTX 5090 - 8900 XTX (9070 XT) Utgivelse dato - Rytker?

N o r e n g svarte på simalarion sitt emne i Skjermkort

Det er en gruppe mennesker som mener at DLSS og TAA gir uklare bilder, og de foretrekker "skarpere" detaljer. Det ironiske er at disse "skarpere" bildene er et resultat av undersampling, og hvis man faktisk øker samplingraten til det ekstreme får man veldig ofte tilsvarende "uskarpe" detaljer. Jeg kan heller ikke forstå meg på de som foretrekker krypende trappetrinn på alle linjer som ikke er parallele med pikslene på skjermen. MSAA er ikke løsningen, med mindre man også går tilbake til 2004-grafikk uten gjennomsiktige effekter eller shadere. Nvidias løsning på dette var først Transparency Supersampling, som selektivt kjørte høyere oppløsning på gjennomsiktige teksturer med ekstrem ytelseskostnad. Neste forsøk var TXAA, som var et tidlig forsøk på TAA. Nå er vi på DLSS, som har kommet nære ved å løse problemet samtidig som ytelsen faktisk blir bedre. Cyberpunk 2077 har allerede den nye DLSS4 patchet inn, så man kan teste selv. Den nye modellen er merkbart bedre i min mening, og gir meg et "gratis" ytelsesløft på mitt eksisterende kort. At Nvidia velger å gi alle RTX-eiere tilgang til den nye modellen er en veldig positiv overraskelse i mine øyne. -

RTX 5090 - 8900 XTX (9070 XT) Utgivelse dato - Rytker?

N o r e n g svarte på simalarion sitt emne i Skjermkort

Som nevnt tidligere. AMD har flyttet 9070-lanseringen til mars -

RTX 5090 - 8900 XTX (9070 XT) Utgivelse dato - Rytker?

N o r e n g svarte på simalarion sitt emne i Skjermkort

SLI har vel ikke vært støttet de siste 6-7 årene nå. -

RTX 5090 - 8900 XTX (9070 XT) Utgivelse dato - Rytker?

N o r e n g svarte på simalarion sitt emne i Skjermkort

9800X3D har ganske mye mer å gå enn 7800X3D, samt litt høyere klokkefrekvens. Med tanke på prisforskjellen for et komplett system blir 700 kr en liten forskjell for 10-20% bedre prosessorytelse. Hvis du skal strekke levetiden lengst mulig bør du definitivt ikke kjøpe et 7900 XTX. Sjansen for at FSR4 lar seg kjøre på et 7900 XTX med akseptabel ytelse er dessverre veldig liten, og du kommer til å trenge oppskalering for å kjøre nye spill når neste konsollgenerasjon rulles ut. Dessuten er Raytracing-ytelsen til 7900 XTX ikke spesielt god, og det vil bli mer og mer vanlig at RT brukes i fremtidige spill. Sats heller på RTX 5080 eller 5070 Ti er min mening, RTX 5090 vil definitivt ikke holde dobbelt så lenge. For 6 år siden var det beste du kunne kjøpe for lignende bruk en Core i9 9900K med et RTX 2080 Ti, den komboen er faktisk ganske akseptabel i dag takket være DLSS selv på 2560x1440. Om 2 år kan det imidlertid hende at arkitekturen er for gammel til å holde stort lengre. -

RTX 5090 - 8900 XTX (9070 XT) Utgivelse dato - Rytker?

N o r e n g svarte på simalarion sitt emne i Skjermkort

CUDA compute capability har gått fra 8.9 på Ada til 10.0 på Blackwell. Ikke akkurat noe som slår ut i spill, men det er en ganske stor forandring. INT/FP32-fordelingen er nå 128:128 i hver SM, dette forbedrer sikkert spillytelsen noe sammenlignet med Ada/Ampere der det var 64:128, og Turing som hadde 64:64. Pascal hadde 128 ALUer som støttet både FP32 og INT RTX Mega Geometry kan håndtere enormt mange flere polygoner sammenlignet med tidligere generasjoner. Ny NVENC støtter 4:2:2 kompresjon av AV1 og HEVC, Ada støttet bare 4:2:0. Dette er en stor forbedring. Display ut-støtten er forbedret kraftig: DP2.1 mot DP1.4 på Ada blant annet. Jeg er enig i at spillytelsen ikke er voldsomt forbedret, men det er teknologisk innovasjon i Blackwell, på samme måte som med Turing. Når det kommer til 5090 spesifikt, så er forbedringen skuffende mest fordi GPU-en er så latterlig diger. På samme måte som 4090 har vist seg å ikke være i nærheten av 60% raskere enn 4080 i spill, vil 5090 heller ikke være i nærheten av 100% raskere enn 5080. Dette er fordi 4090 og 5090 har flere SM-er enn det er mulig å dra nytte av i mange spill, Amdahls lov begynner faktisk å vise seg for spillgrafikk også. Selv det "lille" antallet SM-er man finner på TU102, GA102, AD103, og GB203 stanger inn i Amdahls lov. Veien fremover blir høyere klokkefrekvens, og færre sykluser brukt per instruksjon for å begrense ventetiden på avhengigheter. -

RTX 5090 - 8900 XTX (9070 XT) Utgivelse dato - Rytker?

N o r e n g svarte på simalarion sitt emne i Skjermkort

Lanseringen er i mars, med andre ord "snart" Jeg har personlig erfaring med smeltet 12VHPWR. Brukte offisiell adapter, og hadde kortet på testbenk med pluggen helt inne og kun tyngdekraft som dro på pluggen. Det smeltet likevel. Det har allerede begynt å skje med enkelte 30- og 40-serie kort. -

1. Det har aldri vært sagt at kun menn kan bli witchere. De valgte ut unge gutter fordi man antok at unge gutter hadde bedre sjanse til å overleve mutasjonene enn unge jenter. 2. Det kan jo hende hun blir det, og må bruke list for å overkomme mannlige witchere? Inntil vi får se spillet er ikke dette noen bekymring for min del. 3. Romantikk og kjærlighetsforhold har ikke vært spesielt sentralt i tidligere Witcher-spill? Det har vært noen sidequests relatert til dette, men det er jo langt fra hva spillene handler om? Vi får se hvordan det blir, ikke noe poeng i å dømme helt enda tenker jeg.

- 31 svar

-

- 3

-

-

-

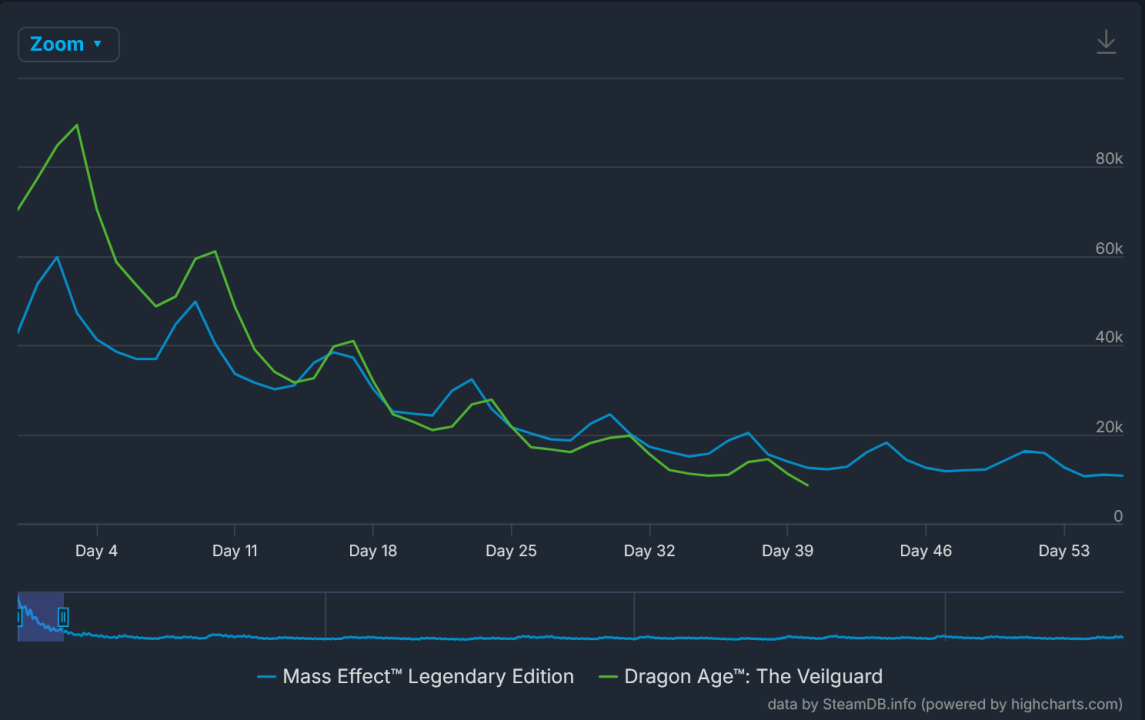

Alt er mulig, men ME: Legendary Edition holdt bedre på spillerne sine enn The Veilguard har gjort...

- 124 svar

-

- 4

-

-

En sammenligning jeg syns er litt avslørende er hvordan The Veilguard ser ut til å miste spillerne betraktelig fortere enn Mass Effect Legendary Edition. Link til original kilde er her: https://steamdb.info/charts/?compare=1328670,1845910&release Her har jeg satt begge spillene til å starte ved lansering og vise antall daglige spillere X dager fra lansering. Mass Effect Legendary Edition tar riktignok lengre tid å spille gjennom, men jeg tror også at en god andel kjøpte det fordi de hadde spilt serien tidligere. Er dette en absolutt målestokk? Nei, men jeg tror det er en ganske brukbar pekepinn.

- 114 svar

-

- 2

-